Forschung

Neue Lernstrategien für Roboter

Roboter sollten den Zweck der Handlungen von Menschen verstehen, fordert Gordon Cheng, Professor für Kognitive Systeme an der Technischen Universität München (TUM). Dann können Roboter von ihnen lernen. Im Unterschied zu bisherigen Ansätzen macht zweckbewusstes Lernen (Purposive Learning) Roboter flexibler und damit besser geeignet für die direkte Kooperation mit Menschen, argumentiert Cheng.

Was genau meinen Sie mit zweckbewusstem Lernen?

Cheng: Menschen und Tiere wenden drei Grundstrategien an, wenn sie andere imitieren und dabei von ihnen lernen. Der erste Ansatz ist erscheinungsbasierend. Das bedeutet, dass wir versuchen, Bewegungen – wie sie uns erscheinen – exakt nachzuahmen. Die zweite Strategie ist aktionsbasierend, man konzentriert sich also darauf zu lernen, welche Aktionen auszuführen sind. Zweckbewusstes Lernen ist der dritte Ansatz, darunter verstehen wir, dass man den Zweck einer Handlung begreift. Das macht es nicht nur einfacher, von anderen zu lernen, sondern macht uns auch flexibler beim Ausführen der Handlungen.

Könnten Sie ein Beispiel dafür geben?

Cheng: Beim Abwaschen beispielsweise ist unser Ziel, am Ende saubere Teller und Tassen zu haben. Wir können uns problemlos an unterschiedlich eingerichtete Küchen, an verschiedene Bürsten und Schwämme und an eine Vielfalt an Geschirr und Besteck anpassen. Den Zweck einer Handlung zu kennen, macht uns extrem effektiv.

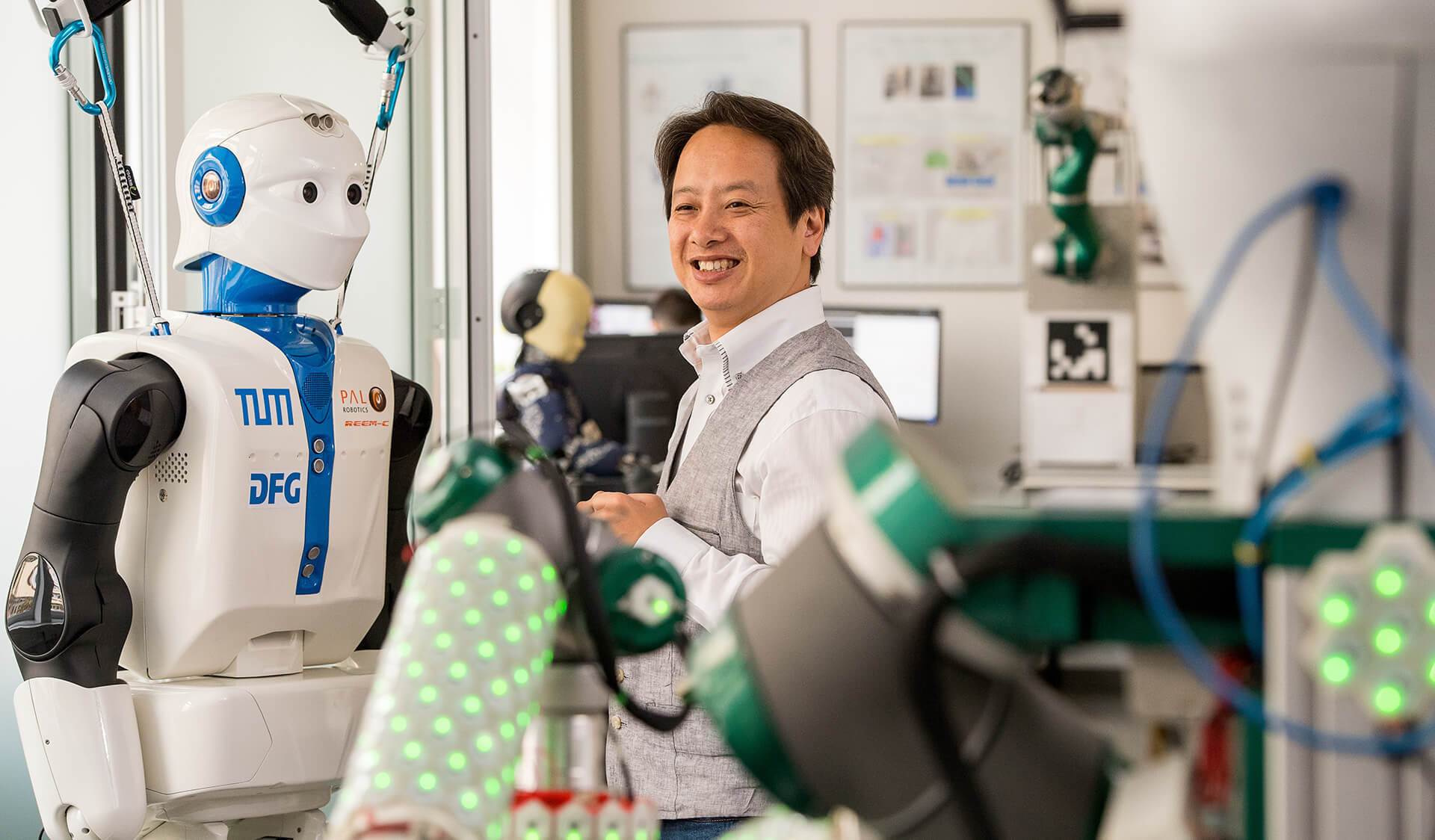

Roboter werden schneller und effektiver zur Kooperation mit Menschen kommen, wenn sie den Zweck von Handlungen kennen. Fotos: TUM

Wie lässt sich das auf Roboter anwenden?

Cheng: Will man dem Roboter eine Aufgabe beibringen, ist es sinnlos, erscheinungsbasierend zu arbeiten, ihn also einen Menschen direkt imitieren zu lassen. Schon der Körper der meisten Roboter ist ja ganz anders geformt als unserer. Würde man die Bewegungen eines Menschen beim Abwaschen eins zu eins auf einen Roboter übertragen, hätte man am Ende vermutlich einen zerbrochenen Teller. Würde man dagegen aktionsbasierend arbeiten und die einzelnen Bewegungen des Roboters programmieren, könnte er einen Teller effektiv abwaschen. Reicht man ihm jedoch nur einen Teller in einer anderen Größe, wird er scheitern.

Wie könnte ein zweckbasierender Ansatz weiterhelfen?

Cheng: Idealerweise sagen wir einem Roboter nur, dass er den Abwasch machen soll, und er erledigt diese Aufgabe ohne weiteren Programmierbedarf. Die Grundidee ist, ihm Wissen zu vermitteln und die Fähigkeit zu geben, anhand dieses Wissens eigenständig Schlussfolgerungen zu ziehen. In unserem Abwasch-Szenario hätte der Roboter eine generelle Vorstellung von Geschirr und davon, was sauber bedeutet, und wüsste, welche Handgriffe nötig sind, um sauberes Geschirr zu erhalten. Dieser Roboter weiß, dass sowohl eine Tasse als auch ein Teller Objekte sind, die gereinigt werden können. Und er kann seine Abwaschstrategie entsprechend anpassen.

Wie vermittelt man einem Roboter dieses Wissen?

Cheng: Eines der Werkzeuge, das wir dazu nutzen ist ein Netzwerk von Ontologien. Die Welt, wie wir sie wahrnehmen, lässt sich in solchen Ontologien ausdrücken, in Beziehungen zwischen Objekten und unseren Aktionen. Wir können für jedes Objekt mögliche und wahrscheinliche Aktionen nennen. Das beginnt mit unserem eigenen Körper. Wir wissen, welche Aktionen unser Arm ausführen kann, unsere rechte Hand, jedes einzelne Glied unserer Finger. Das Gleiche gilt für andere Objekte, zum Beispiel einen Spülschwamm: Sie werden ihn nicht verwenden, um eine Wurst zu schneiden. Vielmehr haben Sie eine mentale Ontologie entwickelt, die Ihnen verrät, dass man einen Schwamm nass machen kann und ihn über eine Oberfläche reiben kann. Ontologien, die wir mit anderen teilen, machen es sehr einfach, Aktionen zu erklären.

Aber wie erklären Sie das einer Maschine? Setzen Sie sich an den Rechner und erstellen Sie gigantische Beziehungsdatenbanken?

Cheng: Ein Ansatz ist es, eine große Zahl an Menschen bei einer Aufgabe zu beobachten und ihre Handlungen zu analysieren. Wir nutzen tatsächlich Abwaschen als eine Möglichkeit, um Wissen zu generieren. Wir haben eine Küche mit Spüle in einer Virtual-Reality-Umgebung erstellt und lassen viele verschiedene Menschen mit ihren unterschiedlichen Körpern und Abwaschtechniken virtuelles Geschirr spülen. Durch spezielle Software ist es möglich, ihre Handlungen in eine Aneinanderreihung von Aktionen zu unterteilen und verwertbare Daten zu generieren.

Müssen Sie das für jede neue Aufgabe von vorne machen?

Cheng: Nein, sobald man eine Beziehungsdatenbank erstellt hat, kann man sie auch für andere Aufgaben nutzen. Wissenschaftler erstellen solche Common-Sense-Datensammlungen seit einiger Zeit. In vielen Fällen existiert schon eine Datenbank für die Grundlagen, auf der man aufbauen kann.

Gibt es noch andere Einsatzmöglichkeiten, außer Robotern Haushaltstätigkeiten beizubringen?

Cheng: Die Möglichkeit, menschliche Handlungen auseinanderzunehmen und sie Maschinen beizubringen, ihren Zweck zu erkennen, eröffnet viele neue Möglichkeiten. Ein Thema, das in Zukunft interessant wird, ist die Mensch-Roboter-Kooperation in der Industrie. Sobald eine Maschine versteht, was ein Mensch tut und welches seine nächste Handlung sein wird – oder sein sollte – kann sie viel effektiver Unterstützung leisten.

Kontakt

Prof. Dr. Gordon Cheng

Lehrstuhl für Kognitive Systeme

Technische Universität München

Tel. +49 89 289-25765

E-Mail senden